¡¿Qué la inteligencia artificial es inteligente?! Parece una broma vieja para expertos en este tema, como Lorena Jaume-Palasí, una de las más reconocidas investigadoras sobre este campo tecnológico, quien en una entrevista la compara con un niño que camina dentro de una habitación chocándose una y otra vez contra la pared hasta encontrar la puerta. Así, trabajan las máquinas y eso no es inteligente señala.

Efectivamente. Las máquinas son programadas para ejecutar determinadas tareas y aunque la inteligencia artificial ha ayudado a automatizar los procesos, lo cierto es que una computadora será muy buena y más eficaz que un humano en lo que ha sido programada, pero no va más allá. La mente humana en cambio no tiene límites, fluye y fluye como un río intempestivo que va en calma o agitado, pero siempre en movimiento. Así somos las personas, vamos adaptándonos.

Por eso será qué quizás desde que se inició esta ola de contenidos falsos circulando por las plataformas de medios sociales y que responde al nombre de desinformación, no ha sido controlada, solo atenuada. El problema no es nuevo, las mentiras y rumores sin fundamento llevan miles de años acompañándonos. Mas, gracias a las redes sociales estos artilugios apócrifos se distribuyen con más agilidad y tienen un nivel de resonancia enorme y creciente.

Al punto que sus efectos tienen la capacidad de generar realidades alternativas, contaminar el debate público, amenazar a la democracia o incluso la integridad y vida de las personas. Sino, basta con recordar su interferencia en las elecciones estadounidenses del 2016 o el genocidio de la etnia Royingha alentado por propaganda desinformativa distribuida por el ejército de Myammar en Facebook, según un informe de la ONG Business for Social Responsibility (BSR).

Escándalos como estos junto a la presión social han impulsado algunos de los últimos ajustes a los algoritmos de las plataformas como Twitter y otras, con el fin de combatir la desinformación. Esto significa un gran cambio, porque finalmente su modelo de negocio se alimenta de mantener a las personas conectadas a las redes sociales la mayor cantidad de tiempo posible, valiéndose de cualquier tipo de contenido atractivo y atrayente, como los tóxicos.

Vale tener presente que investigadores del MIT han demostrado que las publicaciones falsas se esparcen más rápido que las verídicas, mientras que los del Instituto Indio de Tecnología Kharagpur hallaron que los contenidos difundidos por haters o quienes esparcen contenidos de odio se extienden más rápido, lejos y llegan a una audiencia más amplia que otros mensajes.

Por ello los cambios implementados en las redes sociales resultaron significativos, pero otra vez la respuesta lógico-matemática imperante en Sillicon Valley dirigió la estrategia, en lugar de complementarla. Entonces, sofisticadas tecnologías como la IA y ajustes algorítmicos fueron la fórmula para combatir la mentira, el odio y polarización en las redes sociales.

Pues no funcionó. Para muestra, YouTube, que intentó valerse únicamente de la IA para frenar los contenidos falsos sobre el Covid, prescindiendo de moderadores humanos, tuvo que recular, porque sus robots no fueron tan eficaces.

Lo mismo ha pasado con otras redes sociales, como Twitter, Facebook, Tik Tok, etcétera, que pese a haber aplicado cambios a sus plataformas y haberse apoyado en comunidades de verificadores de contenidos falsos o fact-checkers, solo han logrado reducir la circulación de productos desinformativos, pero el problema sigue ahí.

Y es que la IA presume de eficiencia pero no de nuestra inteligencia. Al menos no tiene la lógica adaptativa y elevada del ser humano, capaz de desarmar las estrategias algorítmicas programadas últimamente para combatir la desinformación, como son la detección de hashtags, la desindexación de contenidos para evitar que sean encontrados, el uso de etiquetas de alerta o incluso las más radicales como censurar el contenido falso, lo que ya le pasó al aún presidente estadounidense Donald Trump en más de una ocasión.

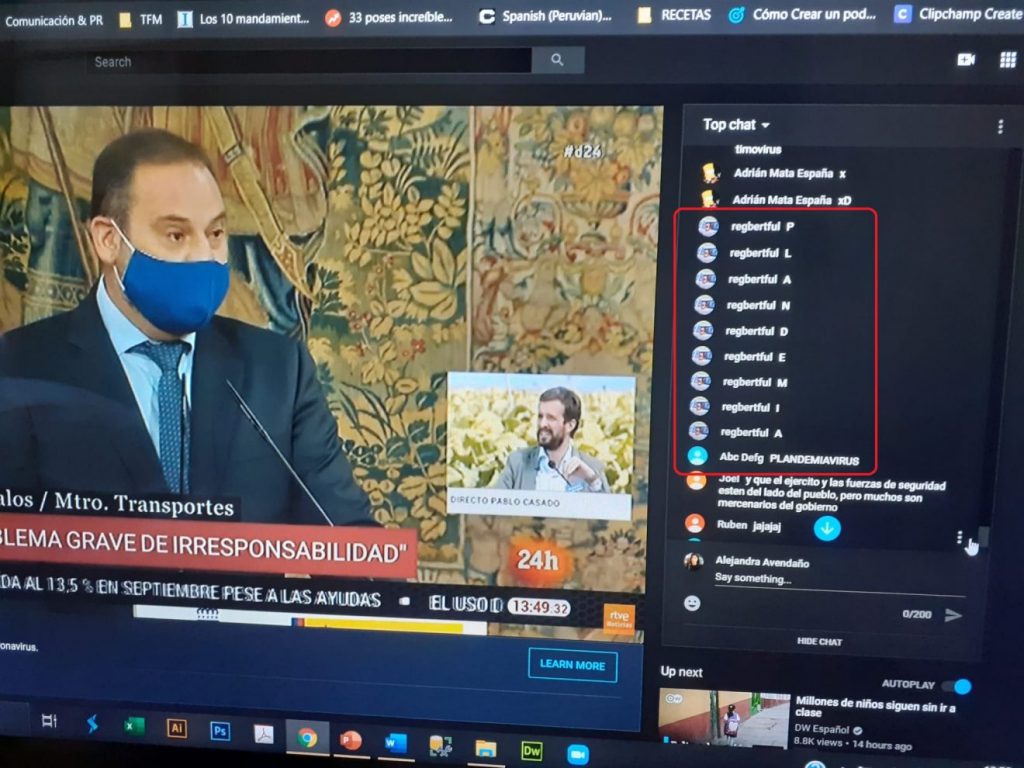

Ya sea un apasionado seguidor de teorías conspiratorias, como los Q´anon, un interesado propagador de contenidos falsos o granjas de trolles, el hecho es que cualquiera de estos actores ha burlado las técnicas de lenguaje predictivo usadas por los robots de IA para detectar la mentira.

Por ejemplo, con tácticas como #typosquating o #OcupaciónMedianteDedazo, que consiste en emular errores ortográficos respecto a un término prohibido o que duplica una de las letras de las palabras censuradas, los desinformadores han evadido los controles algorítmicos y esparcido su contenido falso, valiéndose de las propias plataformas que buscan frenarlos.

La creatividad humana no tiene límites. Y desde ese precepto debiera enfocarse el combate contra la desinformación. Las tecnologías son una herramienta excelente para frenar la circulación de publicaciones falsas y las campañas que buscan desinformar y polarizar, quizás la mejor. Pero la intervención humana dentro del planeamiento y ejecución de este combate es necesaria.

No basta con actuar en el momento, desarticulando la mentira con el fact-checking, que es como curar una herida, sino acompañarlas con medidas preventivas de carácter social e incluir perfiles que vengan del sector de las ciencias sociales y humanidades para construir entornos y sistemas que frenen la difusión de contenidos tóxicos en las redes sociales.

La lucha contra la desinformación no se puede abordar como si se tratara de una escena de Terminator o usando solo a los robots de IA. Se trata de la vida real, en donde las personas interactuamos, tenemos conflictos, prejuicios y venimos de contextos diversos, solo que el resultado de nuestros conflictos se expresa y resuena en las redes sociales. Esto no se resuelve con un algoritmo, sino conociendo a la persona que propaga estos contenidos, entendiendo sus motivaciones y actuando desde un enfoque social y humano.

Add Comment